在大部分的具身机器人还聚焦于基础运动控制(如走路、跑步)时,灵初智能的机器人已经率先攻克了开放场景下的长程复杂任务挑战,和人打起了麻将。

麻将作为策略类博弈棋牌,具有极高的随机性和交互性,对机器人的能力提出了多维要求:首先,机器人需要理解麻将的规则,确保行为符合游戏规则。其次,还需要制定合理的策略,如根据手牌状态、牌局演变以及对手行为来完成动态策略生成,决定出牌、吃碰杠等操作,涉及大量人机交互、机机交互等动作。最后,机器人操作需要完成毫米级精度的抓牌、出牌、理牌等灵巧精细动作。这对机器人的长程任务规划、灵巧操作能力提出了巨大的挑战。

机器人的操作能力分为3个层次:

L1|物体泛化抓取(Pick&Place),但无法实现复杂操作及思考推理 ;

L2|类人操作:握持(Medium wrap)、精确捏取圆盘(Precision disk)、侧捏(Lateral pinch)、 三指捏握 (Tripod)、侧三指捏握(Lateral tripod)、强力抓握球体Power sphere等,但缺失认知决策链条,无法处理多模态复杂指令;

L3|基于Chain of Action Thought(CoAT)框架的自主推理系统,在开放环境下进行自主推理决策,完成长程复杂操作。

只有具备L3的长程CoAT灵巧操作能力,才能理解世界,并将学到的知识迁移到新的环境中落地。“国粹”打麻将则是典型的L3难题,灵初智能凭借其分层端到端VLA+强化学习算法模型Psi-R1,给出了答案。

R1以麻将为场景,展现了机器人在开放环境中的长程灵巧操作能力,达成了30分钟+持续CoAT超长任务时长,同时验证了三重复合交互能力(人-机交互、机-机交互、机-环境交互),体现出VLA的超强推理能力和RL超越人类上限的思考、操作能力。

这项突破性成果标志着具身智能从单一动作执行向完成复杂物理世界感知、推理和执行闭环的关键跃迁,为具身智能真正进入商业场景提供了可落地的技术范式。

透过麻将视频拆解核心能力

在麻将视频中,灵初智能的R1模型展示了从慢脑到快脑一系列能力。

翻牌我也行——将麻将牌翻起来是非常灵巧的操作,很多麻将新手都无法每次都成功翻牌。灵初智能的灵巧手攻克了触觉-视觉模态对齐难题,实现100%准确翻起麻将牌,展现出人类水平的的灵巧操作能力。

碰杠我都会——机器人能够根据牌友的出牌,构建牌局状态机,自主构建碰、杠等策略链,并丝滑地完成碰杠动作。

算牌我最强——在具身智能体的操作任务中,长程规划是一件非常难的事情,机器人能够记得所有人打过的所有的牌,并根据牌桌状况动态规划要打的牌。类似于AlphaGO,这是强化学习带来的强大的预测能力,经由灵初智能的VLA架构实现在具身智能体上。

兄弟最给力——两台机器人相互配合,实现多体协同智能。不仅仅信息共享,互相“看牌”,还能多机配合递牌。

在24年成立之初,灵初智能率先提出分层端到端快慢脑架构技术路线,如今已成为行业共识(S1快脑:潜意识、直觉、运动控制、快速响应;S2慢脑:推理、规划、慢思考、有意识、刻意思考深度)。Physical Intelligence(PI) 从端到端的架构Pi 0升级为分层架构Hi Robot;Figure AI 3月份发布了分层架构HELIX; 此外,Google 于3月底发布了Gemini Robotics, Nvidia 于4月发布了GR00T N1,都是分层架构。

然而,Nvidia机器人高级总监及华盛顿大学教授 Deiter Fox表示,快慢脑架构目前仍存在两个核心问题尚未解决:

1. 如何连接快慢脑,实现慢脑规划和快脑操作的模态对齐;

2. 如何突破模仿学习的瓶颈,训练丰富技能。

灵初智能Psi-R1快慢脑架构,实现模态对齐,结合强化学习达到具身Aha Moment

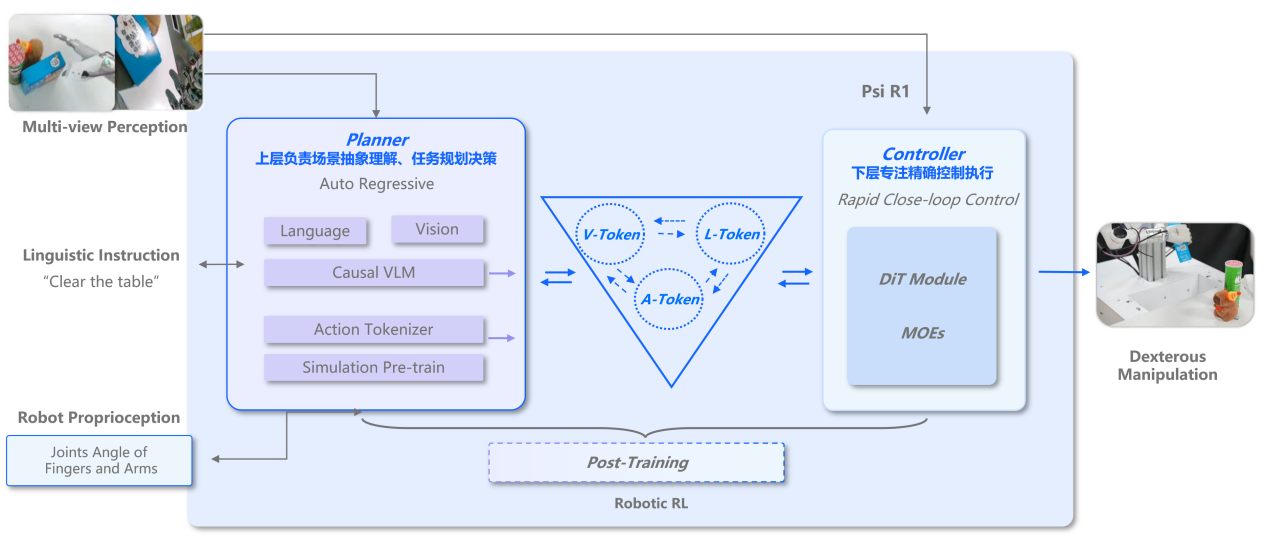

不同于Pi,Figure等「动作单向决策」机制的VLA模型(仅能完成视觉-语言层面的CoT),灵初智能的R1模型的慢脑输入包括行动Token(Action Tokenizer),构建了首个支持「动作感知-环境反馈-动态决策」全闭环的VLA模型,实现机器人操作的视觉-语言-动作多模态协同的的CoAT思维链。

快脑S1专注于操作:

灵巧操作涵盖多种形式,如物体的遮掩抓取(Object Mask-based Grasping)、物体轨迹约束的操作(Trajectory-Constrained Manipulation)如拉拉链、工作使用技能泛化(Tool-using Skills Generalization)如扫码,打电钻、高动态操作(Raw Actions Stream Execution)如抛接球等。灵初智能的RL算法支持上述所有操作类型。

慢脑S2专注于推理规划:

S1的操作经过tokenize后,作为S2慢脑的输入,和语言、视觉模态融合,基于Causal VLM自回归架构,实现多模态融合的推理和任务规划。

快慢脑通过Action Tokenizer隐式连接,端到端训练,协同完成长程任务的灵巧操作。R1模型结合历史动作与当前环境状态,理解动作的长期影响,避免重复试错和动作误差积累,建立动作与环境变化的因果链,解决传统VLM因缺乏动作历史导致的「决策短视」问题。

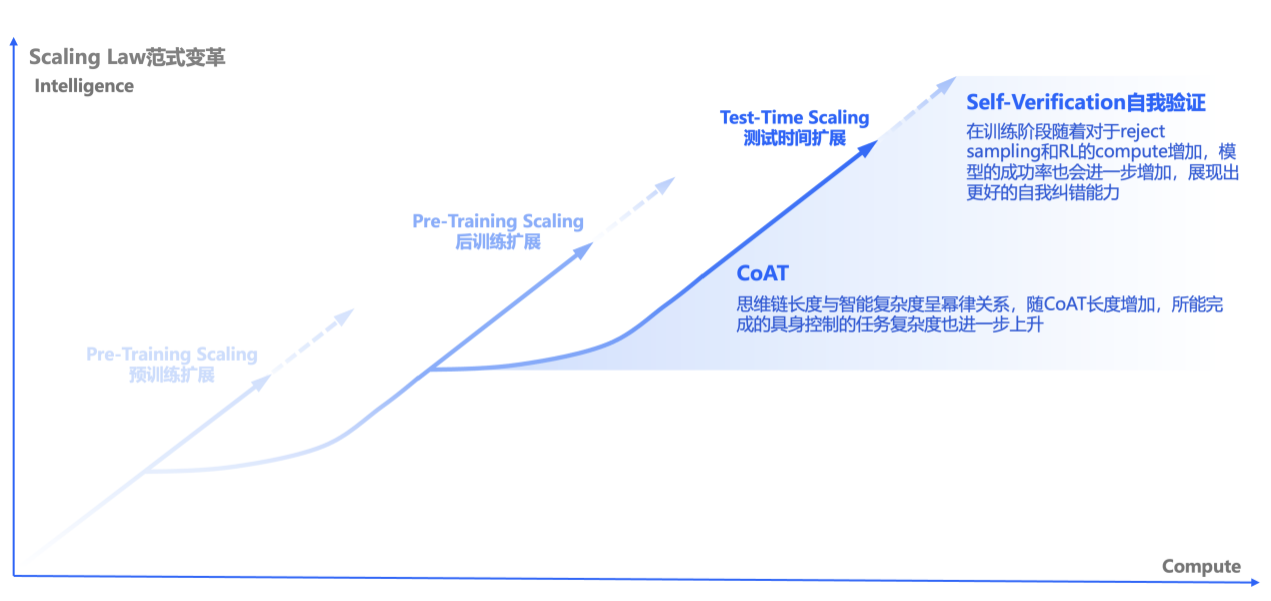

灵初R1模型已首度成功验证VLA Test-Time Scaling

在模型架构不变的前提下,通过RL强化学习框架使其实现自行推演探索解决复杂问题的CoAT,生成能自我验证(self-verification)、反思(reflection)的 Long horizon -CoAT。

自我验证:训练阶段随着对reject sampling和RL的计算量的增加,模型的成功率也会进一步提升,展现出更强的自我纠错能力。

CoAT:思维链长度与智能复杂度呈幂律关系,随CoAT长度增加,可完成的具身控制任务复杂度也进一步上升。

强化学习可以突破模仿学习的瓶颈,

超越人类上限,实现Super Human Intelligence.

Open AI联合创始人Andrej Karpathy指出:

“在儿童学习和深度学习中,存在两种主要的学习类型:

1. 模仿学习(观察并重复,也就是预训练、有监督的微调)

2. 强化学习。AlphaGO战胜人类顶尖围棋手的惊人成就正是基于强化学习的自我对弈,而非模仿专业围棋手来学习。

强化学习驱动的自我验证与反思能突破人类认知上限,这些策略涌现(Emergent)的能力无法通过模仿学习获得,因为模型的认知和人类标注者的认知是不同的,人类永远不会知道如何正确标注这类解题策略,甚至不知道它们应该是什么样子。这些解题策略必须在强化学习过程中被发现。”

24年7月,AlphaProof成为首个在国际数学奥赛中获得奖牌的AI算法,其表现超越了以人类数据为中心的方法。它的强化学习(RL)算法关注与形式证明系统的持续交互,使AlphaProof探索超出人类形式证明范围的数学可能性,从而找到新颖且具有挑战性问题的解决方案。

机器人通过RL也展示了强大的潜能。波士顿动力和宇树的机器人都通过RL实现了如腰关节180度旋转等超越人体上限的关节运动。

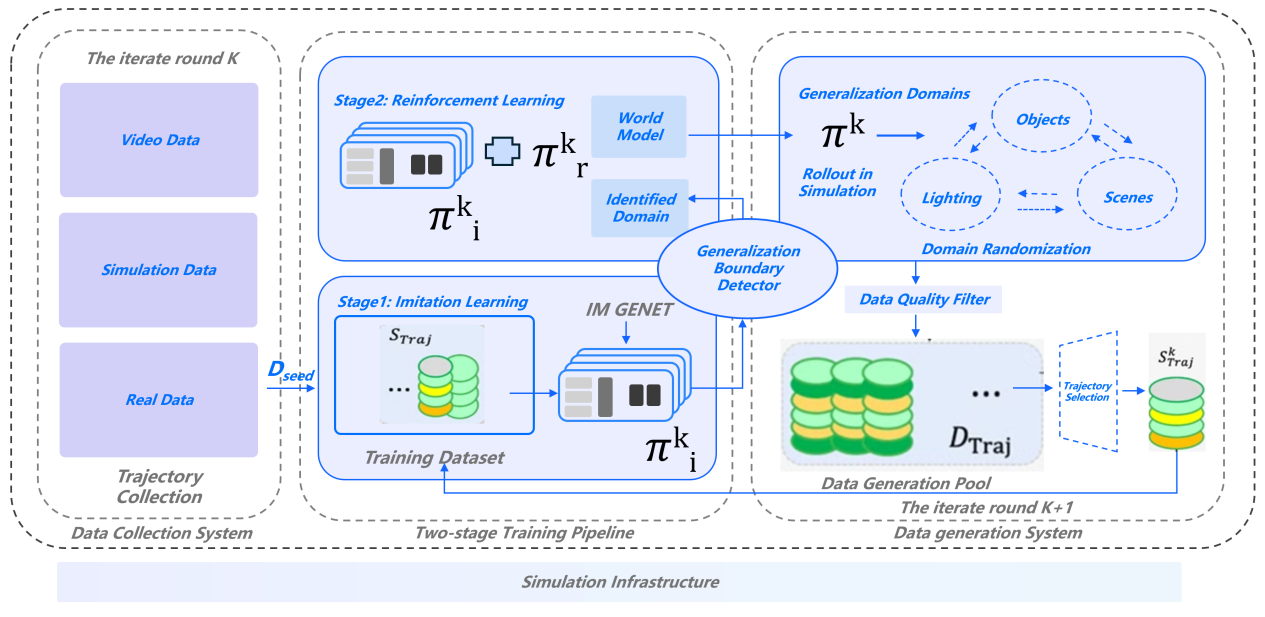

灵初智能贯穿始终的RL应用,高效解决泛化与灵巧操作。在快脑侧,灵初智能还拥有丰富的Sim to Real强化学习经验,可以大规模Scale up训练技能,以RL助力数据使用效率提升至极致,形成数据飞轮。在慢脑侧,通过RL构建任务成功率与CoAT长度的双重突破。

场景应用:L3能力驱动的商业价值释放

灵初智能R1快慢脑系统具备L3能力,可在开放环境下自主推理决策,完成长程复杂操作,其技术可以广泛应用于:

泛工业:来料仓检测、成品包装等场景;

零售物流:拣选、分拨、补货、打包等场景;

2C家庭:家庭服务与协作。

目前,灵初智能已与制造业、商超零售、跨境物流等行业龙头企业展开合作,梯次布局高价值商业化场景,从泛工业向泛零售物流,再最终迈向家庭应用。

灵初智能贯穿始终的RL应用,高效解决泛化与灵巧操作。在快脑侧,灵初智能还拥有丰富的Sim to Real强化学习经验,可以大规模Scale up训练技能,以RL助力数据使用效率提升至极致,形成数据飞轮。在...[详细]

厚普股份相关负责人向记者表示:“我们将千问大模型与氢能业务进行了融合发展。本次AI项目提升了公司的技术壁垒,通过专利级的氢能充装AI管控技术赋能装备智能化升级,有利于巩固公司在清洁...[详细]

4月25日,昆仑万维科技股份有限公司(以下简称“昆仑万维”)发布2024年年度报告。去年,昆仑万维实现营业总收入56.6亿元,同比增长15.2%。整体毛利率达73.6%,继续保持在较高水平。公司继续...[详细]